Como já vimos em outros casos, a IA e a tecnologia de aprendizado de máquina têm um problema grave e inaceitável, o racismo.

De saboneteiras eletrônicas que não detectam mãos de pele escura a carros autônomos que têm 5 por cento mais probabilidade de atropelá-lo se você for negro porque não reconhecem tons de pele mais escuros, existem vários exemplos de algoritmos que não funcionam como deveriam porque não foram testados o suficiente com pessoas não brancas em mente.

No fim de semana, um desses algoritmos com aparente viés chamou a atenção depois que o criptógrafo e engenheiro de infraestrutura Tony Arcieri tentou um experimento simples no Twitter.

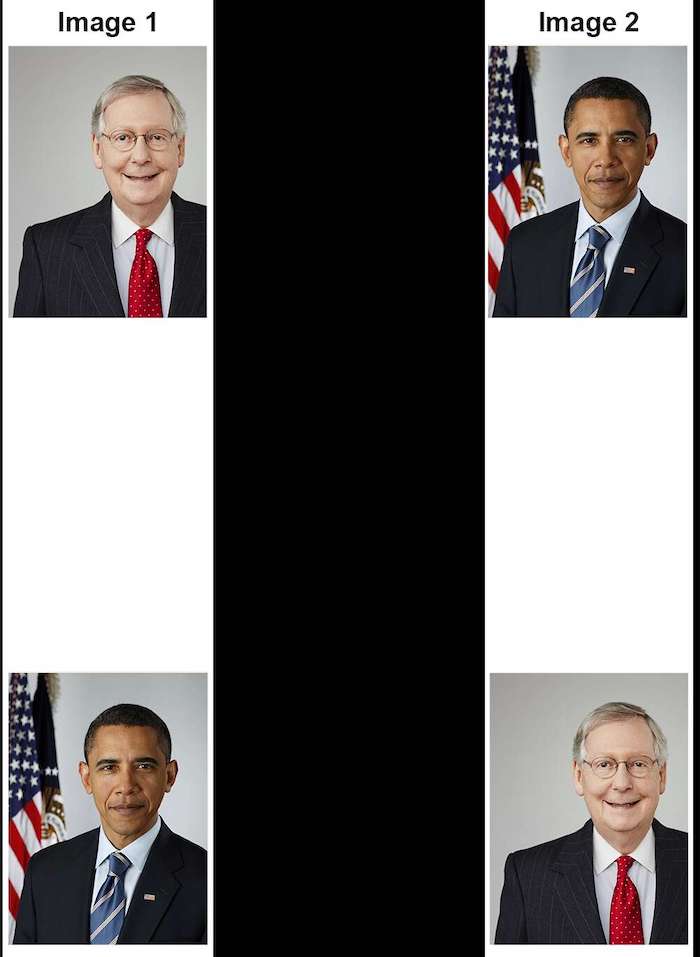

Arcieri tirou duas fotos: uma de Barack Obama e outra de Mitch McConnell. Ele então os organizou como abaixo.

Ele então os carregou no Twitter e clicou em enviar tweet. Nesse ponto, o algoritmo do Twitter corta as fotos automaticamente. A função tem como objetivo selecionar a parte mais relevante da fotografia para exibir a outros usuários.

Aqui está o que o algoritmo selecionou quando recebeu essas duas fotografias.

Como você pode ver, o algoritmo selecionou Mitch McConnell em ambos os casos. Arcieri e outros usuários tentaram variações para ver se o mesmo resultado acontecia, inclusive mudando a cor de suas gravatas e aumentando o número de obamas dentro das imagens.

“É a gravata vermelha! Claramente, o algoritmo tem preferência por gravatas vermelhas!”. Disse ironicamente um usuário da rede.

A defesa do Twitter

“Os engenheiros estudaram e mediram a saliência usando rastreadores oculares, que registram os pixels que as pessoas fixam os olhos”, escreveram os pesquisadores do Twitter Lucas Theis e Zehan Wang.

“Em geral, as pessoas tendem a prestar mais atenção a rostos, textos, animais, mas também a outros objetos e regiões de alto contraste. Esses dados podem ser usados para treinar redes neurais e outros algoritmos para prever o que as pessoas podem querer ver.”

Em essência, o algoritmo pode ser tendencioso porque os próprios dados iniciais foram tendenciosos para imagens de alto contraste, pelas quais nossos cérebros são mais atraídos.

Mas depois que a rede foi bombardeada com outros exemplos de viés racial, a empresa confirmou que estava investigando a situação.

“Testamos o preconceito antes de enviar o modelo e não encontramos evidências de preconceito racial ou de gênero em nossos testes”, respondeu o Twitter. “Mas está claro que temos mais análises a fazer. Continuaremos a compartilhar o que aprendemos, quais ações tomamos e abriremos o código para que outros possam revisar e replicar.”